Quer estudar como notícias falsas e outras mentiras se propagam na internet? Experimente o Twitter Trails, onde cientistas da computação estão treinando um algoritmo para detectar informações incorretas a partir da forma como elas se propagam e como usuários céticos reagem a elas. Ou vá até o Observatory on Social Media, vulgo Truthy, onde uma ferramenta chamada BotOrNot pode detectar o comportamento típico das contas automatizadas que disseminam de informações falsas de teor partidário.

Só há um problema. Estes projetos acadêmicos estão focados no Twitter, por ele ser um sistema aberto que foi configurado para permitir que pessoas de fora trabalhem com seus dados. Ainda assim, é o Facebook — com 1,79 bilhão de usuários ativos mensalmente contra 317 milhões do Twitter — que emergiu como o principal espaço de propagação de notícias falsas politicamente tendenciosas. No entanto, diferentemente do Twitter, o Facebook continua, em grande parte, sendo uma caixa preta.

Em uma pesquisa publicada na semana passada, o BuzzFeed News descobriu que as pessoas que diziam recorrer ao Facebook como sua principal fonte de notícias tinham maior tendência a acreditar em manchetes mentirosas de notícias falsas sobre política. Uma análise anterior do BuzzFeed News já tinha descoberto que as notícias falsas com melhor desempenho relacionadas às eleições americanas de 2016 geraram mais engajamento no Facebook do que notícias embasadas e publicadas pelos principais meios de imprensa nos meses finais da campanha.

Os pesquisadores que estudam a disseminação de mentiras dizem que gostariam de ajudar o Facebook a enfrentar sua crise. No entanto, ainda que o Twitter disponibilize dados em grande volume por meio de uma interface que qualquer pessoa com conhecimentos básicos de programação pode acessar, o Facebook está longe de ser tão aberto.

Hoje em dia, se você quiser trabalhar com dados do Facebook, você tem que se tornar um prestador de serviço, se estabelecer no campus da empresa em Menlo Park (EUA) e concordar com os termos da empresa sobre quais informações poderão ser publicadas.

Para muitos acadêmicos, esse não é um acordo aceitável. "Eu adoraria trabalhar com dados do Facebook", declarou Takis Metaxas — cientista da computação da faculdade Wellesley College em Massachusetts (EUA), que lidera o projeto Twitter Trails — ao BuzzFeed News. "Eles têm que assumir sua responsabilidade por esse grande problema das notícias falsas", acrescentou. "Não só eles facilitaram isso como impediram outras pessoas de ajudarem".

"O Facebook tem que assumir sua responsabilidade por esse grande problema das notícias falsas. Não só eles facilitaram isso como impediram outras pessoas de ajudarem", diz Takis Metaxas, que lidera o projeto Twitter Trails

À medida que cresce a pressão sobre o Facebook para que a empresa exerça maior controle de qualidade sobre o conteúdo que é promovido no Feed de Notícias dos usuários, algumas pessoas argumentam que os riscos são altos demais para que isso aconteça inteiramente a portas fechadas.

De acordo com eles, o Facebook é tão onipresente e tão influente na vida das pessoas que o controle da confidencialidade comercial deveria ser flexibilizado em nome do interesse público.

"[O Facebook] é realmente uma utilidade, com a responsabilidade de uma utilidade pública", disse Micah Sifry — fundador do Civic Hall, entidade sem fins lucrativos pela tecnologia cívica sediada na cidade de Nova York — ao BuzzFeed News.

De fato, as autoridades na Europa observaram perplexas o que aconteceu no Facebook durante as eleições nos EUA, vendo a proliferação de notícias falsas como uma ameaça ao processo democrático. Não é de se espantar que a negativa de Mark Zuckerberg, CEO do Facebook, às alegações de que a desinformação na plataforma influenciou as eleições tenha sido recebida com uma resposta enfurecida. Inclusive, alguns funcionários rebeldes da empresa se comprometeram a formar sua própria força-tarefa para lutar contra as notícias falsas.

O Facebook tem uma ótima equipe de cientistas sociais e de dados, que sabem mais do que qualquer um sobre como as pessoas compartilham conteúdo na plataforma e a influência que ele exerce. "Eles têm gente muito talentosa", disse Fil Menczer, cientista da computação da Universidade de Indiana que conduz o Observatory on Social Media, ao BuzzFeed News.

Certamente que Sifry e outros se perguntam: será que esses funcionários poderiam se unir com especialistas independentes e descobrir uma forma de identificar notícias falsas e evitar que mentiras descaradas poluam os Feeds de Notícias dos usuários do Facebook?

A equipe de pesquisa do Facebook já foi vista como quase uma extensão do meio acadêmico. No passado, os cientistas da empresa cooperaram com pesquisadores acadêmicos renomados e publicaram suas descobertas em revistas científicas.

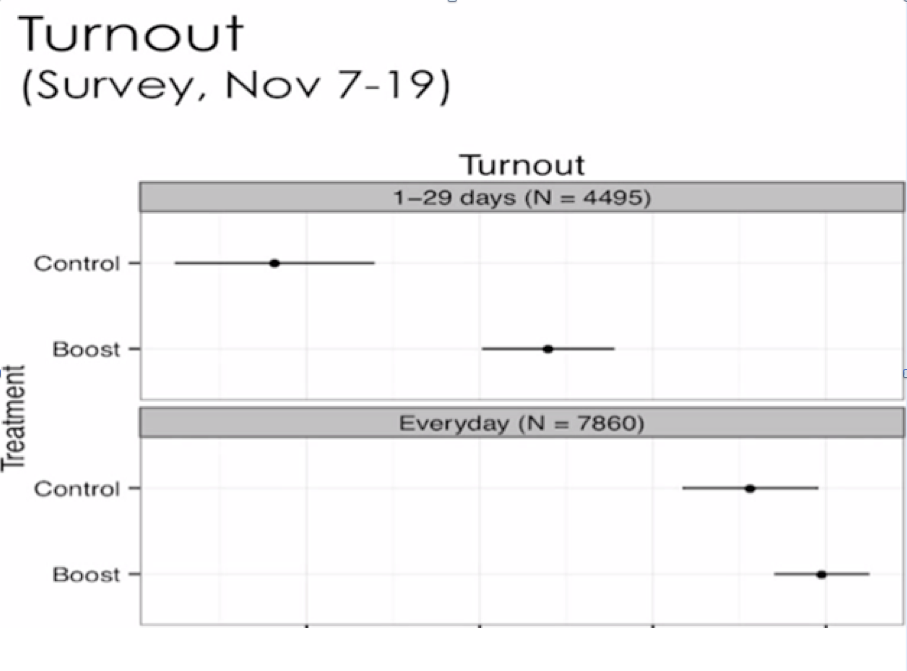

Durante as eleições de 2010 para o Congresso americano, mais de 60 milhões de usuários do Facebook receberam uma mensagem no seu Feed de Notícias incentivando-os a votar e permitindo que clicassem em um botão de "eu votei" para compartilhar sua participação com seus amigos. Dois cientistas do Facebook — trabalhando com uma equipe na University of California, San Diego — liderados pelo cientista social James Fowler, compararam depois os registros de votação das pessoas que viram ou não viram as mensagens. Eles concluíram que só a mensagem incentivou em torno de 60 mil pessoas a irem às urnas, enquanto 280 mil foram levadas a votar à medida que os compartilhamentos de "eu votei" se espalharam pela plataforma.

Em 2012, a importante revista científica Nature publicou os resultados deste experimento sem precedentes, com um título ousado: "Um experimento com 61 milhões de pessoas sobre influência social e mobilização política".

No entanto, nos últimos anos, a pesquisa do Facebook sobre compartilhamento de informações e sua influência nas reações emocionais e no engajamento político das pessoas tem se tornado menos transparente.

O ponto crítico veio em 2014, com a publicação no Proceedings of the National Academy of Sciences (PNAS) de um artigo similarmente provocante chamado "Evidência experimental de contágio emocional em escala massiva por meio das redes sociais".

Adam Kramer, um dos cientistas do Facebook por trás do estudo das eleições, havia se unido com os psicólogos Jeff Hancock e Jamie Guillory, na época ambos na Cornell University, para manipular o que era mostrado no feed de notícias de quase 690 mil usuários do Facebook. Para alguns, os pesquisadores promoveram conteúdo expressando emoções positivas, enquanto publicações com tom negativo eram seletivamente mostradas a outros usuários. Os pesquisadores então rastrearam o que essas pessoas publicaram subsequentemente na plataforma e descobriram que o conteúdo emocional de publicações no Facebook parecia ser contagioso.

O efeito foi pequeno para cada pessoa, mas enorme quando considerado na plataforma como um todo. "No início de 2013, isso teria correspondido a centenas de milhares de expressões emocionais em atualizações de status por dia", concluíram os pesquisadores.

A repercussão negativa foi imediata — e, para o Facebook, foi um desastre de relações públicas. Usuários se opuseram a ter suas emoções manipuladas, manchetes de notícias descreveram o experimento como "sinistro" e o PNAS tomou a iniciativa incomum de publicar uma "expressão de preocupação" sobre a pesquisa. Ao incluir usuários simplesmente por terem concordado com a Política de Uso de Dados do Facebook, o redator-chefe da publicação científica disse que o estudo "pode ter envolvido práticas que não foram completamente consistentes com os princípios de obter consentimento esclarecido e de permitir aos participantes que escolham não participar do estudo".

Hancock, agora na Universidade Stanford, disse ao BuzzFeed News que hoje faria o experimento de forma diferente: segundo ele, já que informar as pessoas sobre os experimentos antes poderia influenciar os resultados, seria melhor contatar os participantes depois, explicando as metas do estudo e permitindo que eles retirassem seus dados da análise caso tivessem objeções.

Alguns usuários do Facebook talvez ainda se preocupem com serem usados como cobaias, mas Hancock e outros cientistas apontaram que testes semelhantes acontecem no Facebook o tempo todo, à medida que engenheiros ajustam o algoritmo que decide quais publicações serão promovidas nos Feeds de Notícias individuais dos usuários.

"O algoritmo definitivo não existe", disse Hancock. "Ele está sendo constantemente ajustado".

A repercussão negativa contra o estudo de contágio emocional deixou o Facebook muito mais cauteloso sobre qual tipo de pesquisa pode ser publicada e como ela deve ser apresentada, de acordo com vários acadêmicos que já trabalharam para o Facebook disseram ao BuzzFeed Notícias. "Não há como negar que isso levou a um controle muito mais estrito sobre as publicações das pesquisas", disse Hancock. Esse controle mais estrito agora dificulta os esforços de pesquisadores independentes para entender o alcance das notícias falsas na plataforma ou o impacto delas sobre os usuários.

Projetos que estudam a influência do Facebook no engajamento político de seus usuários parecem ter se tornado particularmente vulneráveis. No ciclo eleitoral de 2012, a equipe de Fowler e seus colegas no Facebook continuaram os experimentos anteriores de motivação ao voto. Enquanto isso, outro cientista do Facebook, Solomon Messing, experimentou aumentar a proeminência das notícias compartilhadas, em comparação a outros conteúdos, no Feed de Notícias dos usuários. Ele descobriu que isso parecia aumentar o interesse deles em política e a probabilidade de que votassem.

Quatro anos depois, essa pesquisa ainda está para ser publicada — apesar da pressão de fora da empresa. Em 2014, com as eleições para o Congresso americano se aproximando rapidamente, Sifry publicou um artigo para a revista independente Mother Jones descrevendo suas tentativas frustradas de descobrir mais sobre a pesquisa que o Facebook fez no ciclo eleitoral de 2012.

"Sempre me respondiam com sorrisos e obstruções", disse Sifry.

Agora no Pew Research Center em Washington DC, Messing disse ao BuzzFeed News que ele ainda espera publicar os resultados um dia. A breve aparição pública deles foi em um vídeo de uma apresentação em 2013, feita pela cientista do Facebook Lada Adamic, retirada do YouTube a pedido do Facebook após Sifry ter questionado a empresa a respeito.

Os resultados da pesquisa de 2012 de Fowler sobre as eleições definham ainda sem publicação, mas ele os enviou recentemente para que uma publicação científica os revise. Ele se recusou a discutir as descobertas. "Contudo, posso dizer que parte do atraso na publicação foi causado por políticas do Facebook", disse Fowler ao BuzzFeed News. "Se estivéssemos trabalhando com nossos próprios dados, esse artigo provavelmente já teria sido publicado".

Alguns dos colaboradores acadêmicos do Facebook se solidarizam com a cautela da empresa quanto ao que é publicado. "Eles se preocupam muito com a privacidade e a confiança do usuário no sistema", disse Clifford Lampe, da Universidade de Michigan. Os acadêmicos não levam essas questões muito profundamente em consideração, ele observou, enquanto se preparam para publicar suas descobertas.

Lampe já colaborou com várias empresas da área de tecnologia, estudando como as pessoas se comunicam em suas plataformas. Segundo ele, é mais fácil trabalhar com o Facebook do que com a maioria das outras empresas. "Comparativamente, acho que eles fazem um trabalho muito bom de divulgação de sua pesquisa para o público", disse.

Sob circunstâncias normais, debates sobre a transparência das pesquisas de uma empresa de tecnologia seriam uma tempestade em um copo d'água — o confronto entre a cultura acadêmica de questionamento livre e as preocupações de uma empresa com o resultado e com sua imagem pública.

No entanto, após as eleições de 2016 nos EUA terem escancarado o papel do Facebook na divulgação de notícias falsas, tudo mudou.

Pelo que gente de fora sabe sobre a pesquisa do Facebook, a empresa tem a capacidade de estudar sobre a propagação de notícias falsas em sua plataforma e o efeito disso sobre os estados emocionais e sobre o comportamento eleitoral dos usuários. Seus melhores e mais brilhantes funcionários podem muito bem estar trabalhando no problema — o que poderia levar a mudanças importantes no algoritmo que molda os Feeds de Notícias.

No entanto, os críticos da empresa não acreditam que isso esteja mesmo acontecendo a portas fechadas. Em matéria para o New York Times no mês passado, Zeynep Tufekci, tecnossociologista da Universidade da Carolina do Norte, em Chapel Hill, disse que o Facebook deveria "permitir que pesquisadores realmente independentes colaborem com sua equipe de dados para entender e atenuar esses problemas".

"Apenas o Facebook tem dados que podem revelar exatamente como notícias falsas, fraudes e desinformação se espalham, em que quantidade elas existem, quem as cria, quem as lê e quanta influência isso pode ter", escreveu Tufekci. "Infelizmente, o Facebook exerce controle completo sobre o acesso desses dados por pesquisadores independentes. É como se a indústria tabagista controlasse acesso a todos os registros médicos e hospitalares".

Em resposta por e-mail ao BuzzFeed News, Tufekci ressaltou que ela não tem dúvidas quanto à capacidade dos cientistas do próprio Facebook: "A questão é a independência da pesquisa; e a falta de conflito de interesses entre os pesquisadores e suas descobertas".

Um problema da pesquisa do Facebook, Tufekci argumenta, é que ela frequentemente parece talhada para resolver as inquietudes da empresa quanto à sua imagem pública. Segundo ela, até mesmo o estudo polêmico sobre contágio emocional veio após outra pesquisa que sugeria que o uso do Facebook faz as pessoas se sentirem tristes e solitárias. Por isso, a mensagem de que emoções positivas podem ser contagiosas talvez tenha parecido atraente para o Facebook na época.

A pesquisa insistente sobre participação eleitoral, enquanto isso, foi publicada numa época em que o Facebook estava tentando alcançar o Twitter como veículo para compartilhamento de opiniões políticas. Mais recentemente, à medida que as preocupações quanto à influência do Facebook na política crescem, a mensagem parece ter dado uma guinada sutil.

No ano passado, Adamic, Messing e outro cientista do Facebook, Eytan Bakshy, publicaram um estudo na revista Science que rebateu a percepção popular de que as mídias sociais estão alimentando o fanatismo partidário político. (Adamic também mencionou esta pesquisa em sua palestra de 2013.)

O artigo, intitulado "Exposição a notícias e opiniões ideologicamente diversas no Facebook" realmente descobriu que as pessoas estão mais expostas a conteúdo que fortalecem suas opiniões políticas, mas concluíram que a influência do algoritmo do Facebook é pequena se comparada às tendências políticas dos amigos dos usuários no Facebook.

Em resposta às questões do BuzzFeed News sobre a disposição do Facebook em colaborar com cientistas independentes no estudo de notícias falsas, Jodi Seth, diretora de comunicações do Facebook, disse: "Estamos procurando formas de colaborar com peritos externos, incluindo acadêmicos, nestas questões, como fazemos em todas as questões difíceis relacionadas aos nossos produtos e às suas implicações para o mundo".

"Construíram uma plataforma e a venderam para anunciantes como uma ferramenta que influenciava muito as compras das pessoas", disse Sifry. Campanhas políticas têm uma entonação bem parecida. "E aí querem que o resto de nós acredite neles quando dizem que não têm influência nas opiniões políticas das pessoas".

Este post foi traduzido do inglês.